Quantisierung, Projektion und Pruning

Verwenden Sie die Deep Learning Toolbox™ zusammen mit dem Support-Paket für die Model Compression Library der Deep Learning Toolbox, um den Speicherbedarf und die Rechenanforderungen eines tiefen neuronalen Netzes zu reduzieren durch:

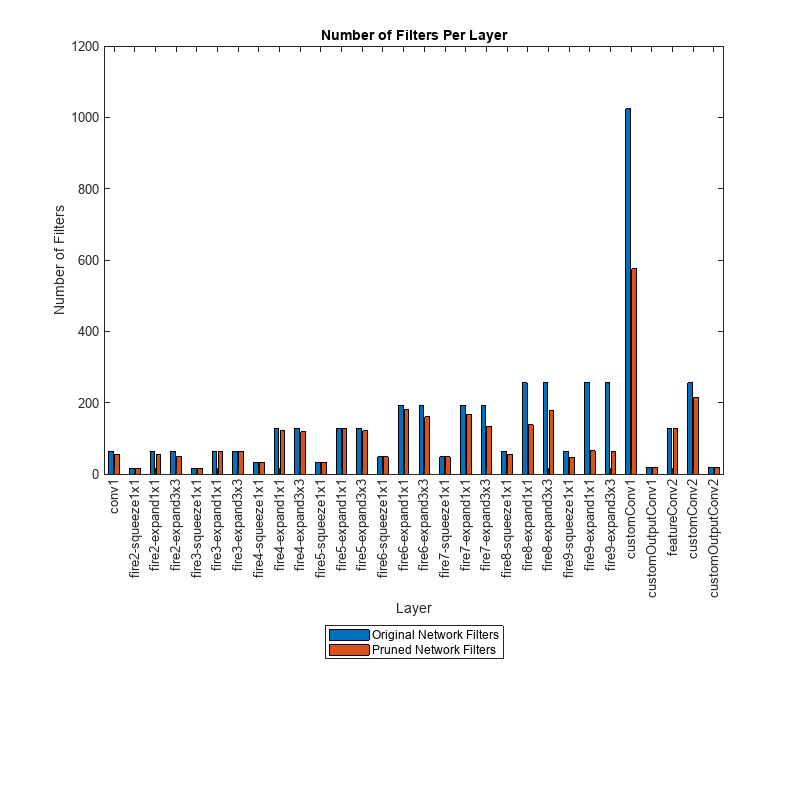

Pruning von Filtern aus Faltungsschichten durch Taylor-Approximation erster Ordnung. Sie können dann C/C++ oder CUDA®-Code aus diesem beschnittenen Netz generieren.

Projektion von Schichten durch Durchführung einer Hauptkomponentenanalyse (PCA) auf die Schichtaktivierungen unter Verwendung eines für die Trainingsdaten repräsentativen Datensatzes und Anwendung linearer Projektionen auf die lernbaren Schichtparameter. Vorwärtsdurchläufe eines projizierten tiefen neuronalen Netzes sind in der Regel schneller, wenn Sie das Netz mit bibliotheksfreier C/C++ Codegenerierung auf eingebetteter Hardware bereitstellen.

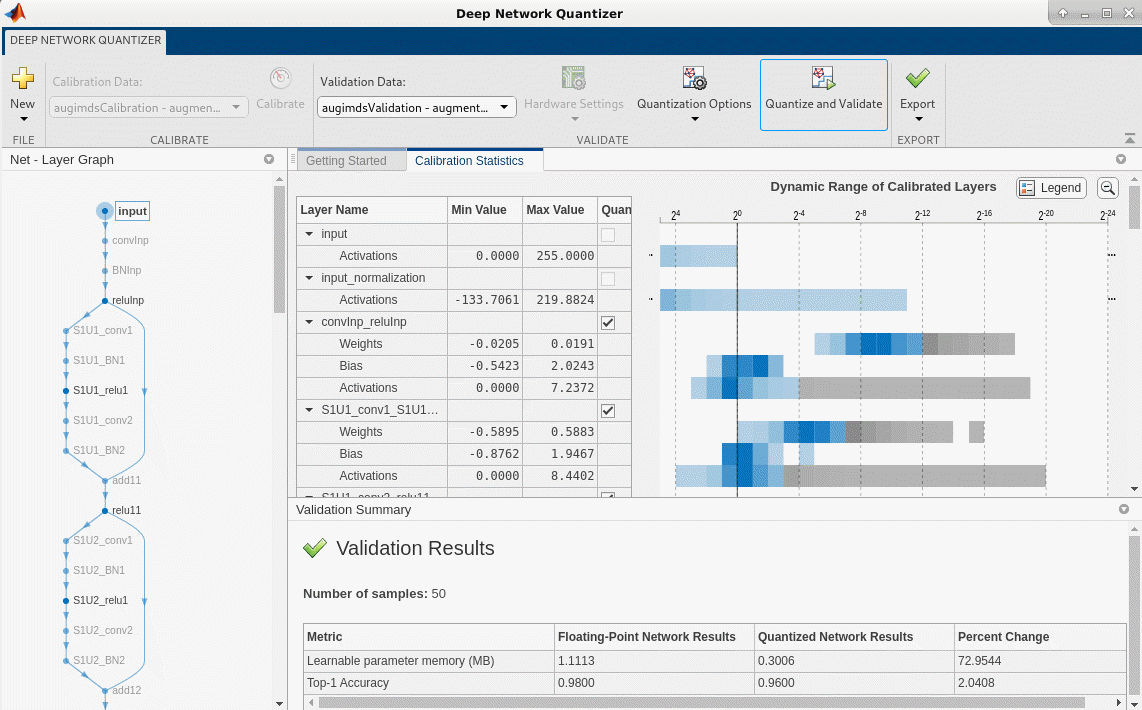

Quantisierung der Gewichte, Verzerrungen und Aktivierungen von Schichten auf skalierte Ganzzahl-Datentypen mit reduzierter Genauigkeit. Aus diesem quantisierten Netz können Sie daraufhin C/C++, CUDA- oder HDL-Code zur Bereitstellung auf GPU, FPGA oder CPU generieren.

Analysieren Sie Ihr Netz für eine Komprimierung mithilfe der Deep Network Designer-App.

Einen detaillierten Überblick über die in der Deep Learning Toolbox Model Compression Library verfügbaren Komprimierungstechniken finden Sie unter Reduce Memory Footprint of Deep Neural Networks.

Funktionen

Apps

| Deep Network Quantizer | Quantize deep neural network to 8-bit scaled integer data types |

Themen

Überblick

- Reduce Memory Footprint of Deep Neural Networks

Learn about neural network compression techniques, including pruning, projection, and quantization.

Pruning

- Analyze and Compress 1-D Convolutional Neural Network

Analyze 1-D convolutional network for compression and compress it using Taylor pruning and projection. (Seit R2024b) - Parameter Pruning and Quantization of Image Classification Network

Use parameter pruning and quantization to reduce network size. - Prune Image Classification Network Using Taylor Scores

This example shows how to reduce the size of a deep neural network using Taylor pruning. - Prune Filters in a Detection Network Using Taylor Scores

This example shows how to reduce network size and increase inference speed by pruning convolutional filters in a you only look once (YOLO) v3 object detection network. - Prune and Quantize Convolutional Neural Network for Speech Recognition

Compress a convolutional neural network (CNN) to prepare it for deployment on an embedded system.

Projektion und Wissensdestillation

- Compress Neural Network Using Projection

This example shows how to compress a neural network using projection and principal component analysis. - Evaluate Code Generation Inference Time of Compressed Deep Neural Network

This example shows how to compare the inference time of a compressed deep neural network for battery state of charge estimation. (Seit R2023b) - Train Smaller Neural Network Using Knowledge Distillation

This example shows how to reduce the memory footprint of a deep learning network by using knowledge distillation. (Seit R2023b)

Quantisierung

- Quantization of Deep Neural Networks

Overview of the deep learning quantization tools and workflows. - Data Types and Scaling for Quantization of Deep Neural Networks

Understand effects of quantization and how to visualize dynamic ranges of network convolution layers. - Quantization Workflow Prerequisites

Products required for the quantization of deep learning networks. - Supported Layers for Quantization

Deep neural network layers that are supported for quantization. - Prepare Data for Quantizing Networks

Supported datastores for quantization workflows. - Quantize Multiple-Input Network Using Image and Feature Data

Quantize Multiple Input Network Using Image and Feature Data - Export Quantized Networks to Simulink and Generate Code

Export a quantized neural network to Simulink and generate code from the exported model.

Quantisierung für GPU-Ziel

- Generate INT8 Code for Deep Learning Networks (GPU Coder)

Quantize and generate code for a pretrained convolutional neural network. - Quantize Residual Network Trained for Image Classification and Generate CUDA Code

This example shows how to quantize the learnable parameters in the convolution layers of a deep learning neural network that has residual connections and has been trained for image classification with CIFAR-10 data. - Quantize Layers in Object Detectors and Generate CUDA Code

This example shows how to generate CUDA® code for an SSD vehicle detector and a YOLO v2 vehicle detector that performs inference computations in 8-bit integers for the convolutional layers. - Quantize Semantic Segmentation Network and Generate CUDA Code

Quantize Convolutional Neural Network Trained for Semantic Segmentation and Generate CUDA Code

Quantisierung für FPGA-Ziel

- Quantize Network for FPGA Deployment (Deep Learning HDL Toolbox)

Reduce the memory footprint of a deep neural network by quantizing the weights, biases, and activations of convolution layers to 8-bit scaled integer data types. - Classify Images on FPGA Using Quantized Neural Network (Deep Learning HDL Toolbox)

This example shows how to use Deep Learning HDL Toolbox™ to deploy a quantized deep convolutional neural network (CNN) to an FPGA. - Classify Images on FPGA by Using Quantized GoogLeNet Network (Deep Learning HDL Toolbox)

This example shows how to use the Deep Learning HDL Toolbox™ to deploy a quantized GoogleNet network to classify an image.

Quantisierung für CPU-Ziel

- Generate int8 Code for Deep Learning Networks (MATLAB Coder)

Quantize and generate code for a pretrained convolutional neural network. - Generate INT8 Code for Deep Learning Network on Raspberry Pi (MATLAB Coder)

Generate code for deep learning network that performs inference computations in 8-bit integers. - Compress Image Classification Network for Deployment to Resource-Constrained Embedded Devices

This example shows how to reduce the memory footprint and computation requirements of an image classification network for deployment on resource constrained embedded devices such as the Raspberry Pi™.