Überprüfung

Die Deep-Learning-Überprüfung ist eine Reihe von Techniken zur Bewertung der Eigenschaften von tiefen neuronalen Netzen. So können Sie beispielsweise die Fehlerresistenzeigenschaften eines Netzes überprüfen, Grenzen für die Netzausgabe berechnen, gegnerische Beispiele finden, Daten außerhalb der Verteilung erkennen und die Einhaltung von Industriestandards überprüfen.

Die Deep Learning Toolbox-Verifikationsbibliothek ermöglicht das Testen der Fehlerresistenzeigenschaften von Deep-Learning-Netzen.

Verwenden Sie die Funktion

verifyNetworkRobustness, um die Robustheit des Netzes gegenüber manipulierten Beispielen zu überprüfen. Ein Netz ist robust gegenüber manipulierten Eingaben, wenn sich die vorhergesagte Klasse des Netzes nicht ändert, wenn die Eingabe zwischen der festgelegten unteren und oberen Eingabegrenze gestört wird. Für einen Satz von Eingangsgrenzen prüft die Funktion, ob das Netz robust gegenüber manipulierten Beispielen zwischen diesen Eingangsgrenzen ist, und gibt entwederverified,violatedoderunprovenaus.Verwenden Sie die Funktion

estimateNetworkOutputBounds, um den Bereich der Ausgangswerte abzuschätzen, den das Netz zurückgibt, wenn die Eingabe zwischen den angegebenen unteren und oberen Grenzen liegt. Verwenden Sie diese Funktion, um abzuschätzen, wie empfindlich die Netzvorhersagen auf Eingabestörungen reagieren.Verwenden Sie die Funktion

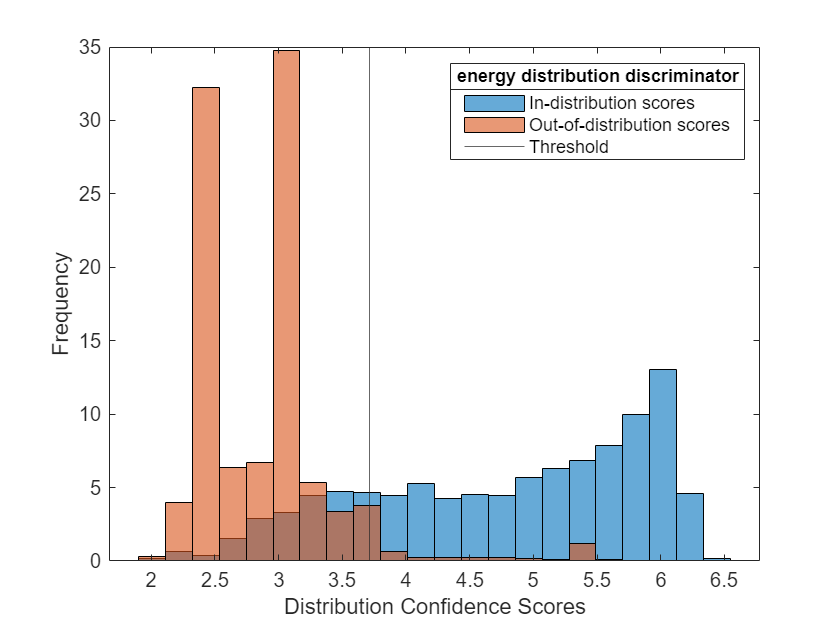

networkDistributionDiscriminator, um einen Verteilungsdiskriminator zu erstellen, der eine Unterteilung in Daten innerhalb und Daten außerhalb der Verteilung vornimmt.

Funktionen

estimateNetworkOutputBounds | Estimate output bounds of deep learning network (Seit R2022b) |

verifyNetworkRobustness | Verify adversarial robustness of deep learning network (Seit R2022b) |

networkDistributionDiscriminator | Deep learning distribution discriminator (Seit R2023a) |

isInNetworkDistribution | Determine whether data is within the distribution of the network (Seit R2023a) |

distributionScores | Distribution confidence scores (Seit R2023a) |

drise | Explain object detection network predictions using D-RISE (Seit R2024a) |

deep.gpu.deterministicAlgorithms | Set determinism of deep learning operations on the GPU to get reproducible results (Seit R2024b) |

Objekte

BaselineDistributionDiscriminator | Baseline distribution discriminator (Seit R2023a) |

EnergyDistributionDiscriminator | Energy distribution discriminator (Seit R2023a) |

ODINDistributionDiscriminator | ODIN distribution discriminator (Seit R2023a) |

HBOSDistributionDiscriminator | HBOS distribution discriminator (Seit R2023a) |

Themen

- Verification of Neural Networks

Learn about verification of neural networks using Deep Learning Toolbox™ Verification Library.

- Verify Robustness of Deep Learning Neural Network

This example shows how to verify the adversarial robustness of a deep learning neural network.

- Verify Robustness of ONNX Network

This example shows how to verify the adversarial robustness of an imported ONNX™ deep neural network. (Seit R2024a)

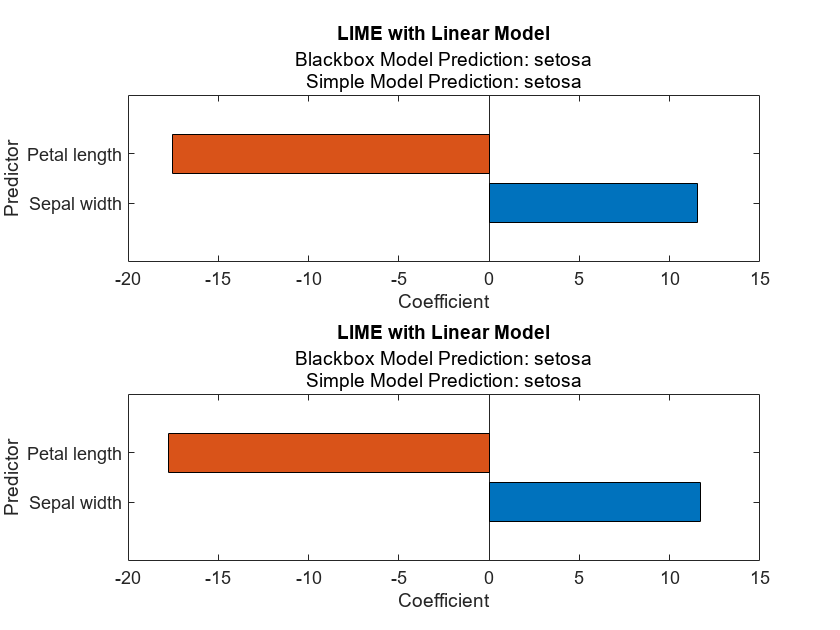

- Deep Learning Visualization Methods

Learn about and compare deep learning visualization methods.

- Out-of-Distribution Detection for Deep Neural Networks

This example shows how to detect out-of-distribution (OOD) data in deep neural networks.

- Verify an Airborne Deep Learning System

This example shows how to verify a deep learning system for airborne applications and is based on the work in [5,6,7], which includes the development and verification activities required by DO-178C [1], ARP4754A [2], and prospective EASA and FAA guidelines [3,4]. (Seit R2023b)

- Uncertainty Estimation for Regression (Statistics and Machine Learning Toolbox)

Learn about estimating the uncertainty of the true response for a regression problem.